IA génératives : une révolution en cours ?

Publié en ligne le 17 octobre 2023 - Intelligence Artificielle -

L’intelligence artificielle est une discipline née dans les années 1950, quasiment en même temps que l’informatique. Elle a connu une histoire mouvementée, ponctuée par des vagues d’enthousiasme et des périodes de repli, parfois victime de ses propres prédictions triomphalistes. Dans les années 1980, l’IA dite symbolique (manipulant des connaissances sous formes de symboles et de propositions logiques) produit des résultats remarqués. C’est l’époque des « systèmes experts », ces programmes informatiques qui résolvent des problèmes très précis en utilisant une somme de connaissances pointues (parfois obtenues auprès d’experts du domaine) et des « heuristiques » bien adaptées. Elle prend le dessus sur l’approche dite « connexionniste », (à base de « réseaux de neurones artificiels », programmes d’informatiques fondés sur des techniques d’apprentissage automatique, ou machine learning en anglais – voir l’encadré ci-dessous).

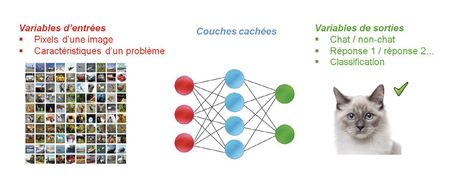

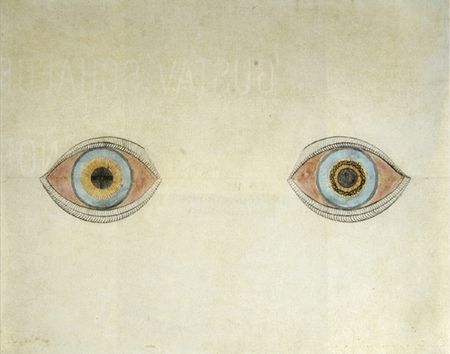

Le composant de base des réseaux de neurones artificiels utilisés en IA peut être schématisé comme une entité disposant de plusieurs entrées pouvant prendre différentes valeurs (par exemple binaires : 0 ou 1) et d’une sortie. Une fonction mathématique va déterminer la valeur de sortie en fonction des valeurs d’entrée. Un « poids synaptique » associé à chacune des entrées permet d’en pondérer l’importance.

Un réseau de neurones artificiel est une association d’un certain nombre de ces « neurones artificiels ». Le réseau est généralement organisé en couches successives où les sorties d’une couche constituent les entrées d’une autre. Les entrées du premier niveau modélisent le problème que l’on veut résoudre (par exemple, en associant chaque pixel d’une image dont on veut reconnaître le contenu à une entrée) et les sorties du dernier niveau représentent la réponse attendue (par exemple 1 pour dire que le système a reconnu un chat et 0 pour dire qu’il n’en a pas reconnu). Entre les deux, les valeurs calculées sont transmises d’une couche à la suivante.

La fonction mathématique implémentée par ces couches successives doit résoudre le problème posé (par exemple, reconnaître la présence d’un chat sur une photo codée par ses pixels). Toute la difficulté consiste à trouver les bons paramètres (poids synaptique et autres paramètres) de chacun des neurones afin d’obtenir les sorties désirées avec le plus de pertinence possible. Un opérateur humain voulant régler manuellement chacun de ces paramètres n’aurait aucune chance de réussir cette tâche, car nulle part dans le système n’est codé explicitement ce qui caractérise un chat (moustaches, oreilles pointues, etc.). Il est donc impossible de raisonner directement sur les paramètres du réseau (ni, d’ailleurs, a posteriori, d’utiliser ces valeurs pour expliquer la décision). On met alors en place des méthodes dites d’« apprentissage automatique » où l’ordinateur va lui-même procéder à l’ajustement des paramètres qui vont encoder la fonction à réaliser. Ces méthodes, de plus en plus sophistiquées, reposent sur des algorithmes fondés sur des mathématiques complexes qui permettent de faire varier progressivement les paramètres du réseau afin d’approcher le plus possible du résultat voulu.

Dans l’« apprentissage supervisé », le réseau va être forcé à converger vers des valeurs prédéfinies. Par exemple, on lui soumettra un jeu de données labellisées (des photos associées à l’indication « chat » ou « non chat ») et les paramètres devront évoluer de telle sorte que, à la fin de l’apprentissage (ou « entraînement »), le système reconnaisse bien les chats, et uniquement les chats. À l’inverse, dans l’« apprentissage non supervisé », le réseau converge par lui-même vers des solutions stables.

Si les premières applications des réseaux de neurones comportaient quelques milliers de paramètres, les nouveaux systèmes aujourd’hui déployés peuvent en compter des millions ou des milliards. Ainsi GPT3, au cœur de ChatGPT, comporte-t-il 175 milliards de paramètres qui seront ajustés lors de la procédure d’apprentissage.

C’est maintenant cette dernière qui domine depuis le début des années 2000. Ce succès s’explique par des résultats impressionnants permis par la puissance accrue des machines 1, les grandes quantités de données issues d’Internet et le perfectionnement d’algorithmes spécifiques mis au point à la fin des années 1990 [1]. Les performances de ces systèmes dédiés à des tâches spécifiques sont au rendez-vous. Ils sont intégrés dans des applications nous faisant oublier la technologie sous-jacente (traduction automatique, assistants vocaux, traitement d’image sur smartphone, moteurs de recherche, aide à la conduite, véhicules autonomes, aide au diagnostic, interprétation de clichés radiographiques, etc.).

Les « intelligences artificielles génératives » (qui produisent un contenu nouveau et original à partir de données ayant servi à leur apprentissage) dont il est question aujourd’hui s’inscrivent dans ce courant connexionniste. Si ChatGPT, tout comme Bard de Google, porte sur la génération de texte, des outils qui génèrent des images et des vidéos sont déjà disponibles. Ces systèmes sont âprement commentés quant aux potentiels risques qu’ils peuvent représenter, tant le réalisme des images générées est saisissant. Mais ils suscitent également un engouement dans le monde de la création graphique.

Des performances impressionnantes

Il est indéniable que les réponses fournies par ChatGPT impressionnent tous ceux qui l’ont testé. Cependant, certains problèmes apparaissent assez vite, comme les fameuses « hallucinations » – des erreurs factuelles rappelant que ces systèmes créent du contenu plausible mais pas nécessairement vrai. Mais ce qui frappe avec les nouvelles IA génératives, c’est leur caractère généraliste, leur capacité à traiter, du moins en apparence, de tous les sujets.

Vers une IA généraliste ?

L’intelligence artificielle, en tant que discipline scientifique, a souvent été décrite en distinguant l’« IA faible » et l’« IA forte ». L’IA faible, parfois dénommée « IA étroite », est celle qui s’est déployée jusqu’à aujourd’hui. Elle est conçue pour effectuer une tâche spécifique et n’a aucune capacité à s’appliquer à un autre type de problème. À l’inverse, l’IA forte, parfois dénommée « IA générale », serait capable de comprendre, d’apprendre et d’appliquer son intelligence à n’importe quelle tâche intellectuelle qu’un être humain peut envisager. Une IA forte aurait en outre une capacité de compréhension et une forme de conscience de soi similaires à celles d’un être humain. L’arrivée des IA génératives marque-t-elle les prémices d’une IA forte ?

Un groupe de chercheurs des équipes de Microsoft (par ailleurs, un des principaux investisseurs d’OpenAI, la société qui produit ChatGPT) a procédé à une analyse des performances et des limites de ChatGPT et a pré-publié 2 ses résultats dans un article évoquant une « étincelle vers une intelligence générale » [2]. Ils examinent de nombreuses prouesses réalisées par le logiciel : écriture d’un programme générant une image selon une description donnée, analyse et reprise d’un code informatique existant pour l’améliorer en suivant des spécifications, résolution de problèmes mathématiques et discussion de la méthode de démonstration, dialogue avec un interlocuteur en prenant en compte ses émotions, etc. Bien entendu, ces tests mettent en évidence certaines limites du système. Mais, pour les auteurs, on a bien là les prémices d’une intelligence générale, même s’ils soulignent qu’il sera nécessaire, pour aller de l’avant, d’hybrider ces systèmes avec une approche symbolique plus classique.

Certes, les mises à jour qui se succèdent améliorent, parfois de façon significative, certains des défauts identifiés (et qui sont souvent très médiatisés : les doigts mal représentés dans les images générées, les biographies fantaisistes de personnes célèbres, etc.). Mais, comme le notent deux spécialistes du sujet, « cela conduit à une question troublante : comment ces systèmes peuvent-ils être si intelligents, tout en semblant si limités ? » [3]. Et ils n’imaginent pas une évolution vers une intelligence artificielle générale par simple extrapolation de l’existant. Pour eux, ce qui est en cause, c’est le fait que la langue et son analyse, aussi sophistiquée soit-elle, ne produira jamais autre chose qu’une compréhension superficielle. Or, ce qui caractérise les êtres humains (et aussi les animaux), c’est leur capacité à interagir physiquement avec le monde extérieur et apprendre de ces interactions [4].

Des performances sans compréhension ?

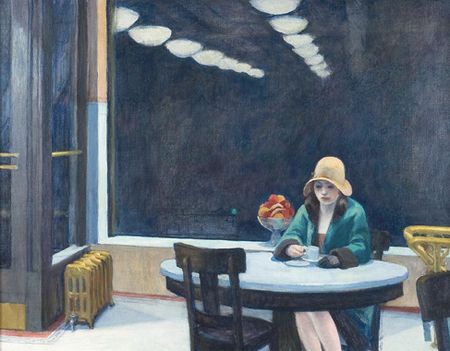

La capacité de ces intelligences artificielles génératives à produire des résultats sophistiqués, sans aucune représentation explicite des concepts manipulés, est à la fois remarquable et surprenante. En simplifiant, on peut dire que ces performances reposent principalement sur un algorithme qui a « appris à terminer des phrases ». Pourtant, l’observateur humain qui examine les productions de ChatGPT lui attribue immédiatement des intentions, une compréhension (voir illustration en encadré) et, finalement, une forme d’intelligence. Le fait que le système soit capable, en apparence, d’expliquer et d’argumenter (en réalité, il n’explique pas un raisonnement qu’il aurait suivi mais produit un texte cohérent avec ce qu’il a généré) renforce la tendance anthropomorphique à vouloir attribuer une intentionnalité à tous les comportements observés.

Pour autant, est-ce que ceci invalide l’émergence d’une « véritable intelligence » ? Notre propre conscience de nous-mêmes n’est-elle pas elle aussi le produit d’une activité neuronale qui ne représente aucun concept explicitement ? On retrouve là le débat, jamais tranché, sur ce qu’est vraiment l’intelligence et sur le fait que des machines puissent ou non penser. Ce débat remonte au tout début de l’histoire de l’intelligence artificielle, dans les années 1950 [5], et est loin d’être clos.

Quels domaines d’application ?

L’engouement pour ces nouveaux systèmes touche le monde de l’entreprise et concerne de nombreux domaines d’activité. Le Hub France IA, association qui regroupe plus de 150 acteurs du domaine, identifie au moins quatre grands types de capacités de ChatGPT qui seraient particulièrement utiles [6].

- La capacité de rédaction pourrait être mise à profit pour générer de nouveaux contenus (articles, newsletter, voire livres), pour aider à répondre à des courriels, améliorer l’expérience client sur les sites, faire des comptes rendus de réunion, mais aussi pour générer ou reprendre des codes informatiques.

- La capacité de classification permettrait d’organiser de la documentation, de trier de grandes quantités de documentation textuelle (analyse d’enquêtes, contenus de mails clients, avis en ligne, etc.).

- La capacité de traduction, que ce soit à l’écrit ou à l’oral.

- La capacité de synthèse, utilisable par exemple pour traiter de grandes quantités d’information dans des processus de veille informationnelle.

Les potentiels domaines d’applications sont légion et la plupart des fonctions dites tertiaires pourraient être impactées. L’intégration d’IA génératives pourrait également profondément bouleverser les moteurs de recherche (en donnant, en plus de liens vers des sites, une réponse plus directe à la question posée, la possibilité d’engager un dialogue, de raffiner la question, de discuter des réponses faites, etc.) ou encore les suites bureautiques…

L’exemple suivant (réalisé avec ChatGPT-4) illustre une interaction très réaliste qui donne l’impression que le système « comprend » la situation décrite et la réflexion d’un des protagonistes.

La requête

« Le chef de Lucas lui a demandé de rédiger un important rapport pour lundi prochain. Lucas lui a répondu en disant qu’il avait besoin de plus de temps. Mais son chef a insisté. Lucas lui a alors répondu qu’il aurait son rapport lundi. Après cela, Lucas a fait autre chose et n’a finalement pas rédigé le rapport. Il a passé son temps à répondre à des mails, à prendre un café avec des collègues ainsi que d’autres choses peu importantes. Pourquoi Lucas s’est-il comporté ainsi ? »

ChatGPT

« Le comportement de Lucas dans cette situation peut être dû à plusieurs facteurs :

- Procrastination : Lucas peut avoir tendance à remettre les tâches importantes à plus tard, ce qui peut conduire à des retards et à un manque de productivité. Il peut être plus enclin à s’engager dans des activités moins exigeantes ou agréables, comme répondre à des e-mails ou prendre un café, plutôt que de se concentrer sur une tâche plus complexe comme la rédaction du rapport.

- Manque d’organisation : Lucas peut ne pas avoir établi de plan clair pour la rédaction du rapport, ce qui peut entraîner une gestion inefficace de son temps et de ses priorités. Sans une structure et des échéances définies, il peut être facile de se laisser distraire par d’autres activités moins importantes.

- Sous-estimation de la charge de travail : Lucas peut avoir sous-estimé le temps et les efforts nécessaires pour rédiger un rapport de qualité. Il peut avoir pensé qu’il avait suffisamment de temps pour le compléter, mais en réalité, il s’est retrouvé dépassé par la complexité de la tâche et n’a pas pu la mener à bien.

- Difficulté à dire non : Lucas a peut-être du mal à dire non à son chef ou à gérer les attentes. Même s’il a initialement exprimé qu’il avait besoin de plus de temps, il a finalement accepté de livrer le rapport pour lundi sans prendre en compte ses autres obligations ou la réalité de sa charge de travail.

Il est important de noter que ces hypothèses sont basées sur des suppositions générales et qu’il est préférable de discuter directement avec Lucas pour comprendre les raisons spécifiques derrière son comportement dans cette situation. »

Source

Exemple généré sur ChatGPT 4, mai 2023, d’après Bubeck S et al., “Sparks of artificial general intelligence : early experiments with GPT-4”, 2023, 1-155. Sur arxiv.org (pré-publication non évaluée par les pairs).

Quels seront les impacts sur les emplois ? Impossible de le dire précisément aujourd’hui, malgré toutes les déclarations qui inondent les médias (encadré ci-après). Ce qui est certain, c’est que ChatGPT a déjà pénétré dans de très nombreuses entreprises du numérique.

De très nombreuses déclarations spectaculaires, mais souvent contradictoires, sont mises en avant dans les médias. Petit florilège trouvé sur Internet (mai 2023) : « 80 % des emplois risquent d’être affectés par l’IA générative », « L’intelligence artificielle générative crée plus de métiers qu’elle n’en élimine », « L’IA générative pourrait menacer 300 millions d’emplois », « ChatGPT : voici les métiers les plus menacés d’un grand remplacement par l’IA », « 34 métiers qui ne seront pas remplacés par l’IA », « L’intelligence artificielle, une précarisation de l’emploi plus qu’une destruction », « Non, l’IA ne va pas tuer le métier de développeur », « L’intelligence artificielle va-t-elle tous nous mettre au chômage ? »

C’est une étude menée en 2023 par le cabinet Goldman Sachs [1] qui évoque le chiffre de 300 millions d’emplois exposés à une automatisation. De façon plus précise, le rapport indique qu’« environ les deux tiers des emplois [en Europe et aux USA] seront exposés à un degré ou un autre à une automatisation des tâches par l’IA et que les IA génératives pourraient remplacer jusqu’à un quart des emplois ». Dans le même temps, la productivité du travail serait accrue avec un impact positif sur le PIB estimé à 7 % par an. Ces prédictions se fondent sur des modélisations qui intègrent de nombreux paramètres tels que la description détaillée des emplois et leur degré potentiel d’automatisation, le coût du travail et de son remplacement ou encore les gains de productivité attendus. Une autre étude estime qu’« environ 80 % de la main-d’œuvre américaine pourrait voir au moins 10 % de ses tâches professionnelles affectées par l’introduction de nouveaux systèmes d’intelligence artificielle » [2]. De son côté, le président-directeur général d’IBM prévoit que « 30 % [des 26 000 employés administratifs] pourraient facilement être remplacés par l’IA et l’automatisation sur une période de cinq ans » [3].

Il est en réalité très difficile de prédire ce qu’il va réellement se passer, ne serait-ce que parce que nous ne sommes qu’au début d’un processus d’innovation technologique et que l’on ne sait pas vraiment ce que seront ses développements dans les années à venir. Les chemins qu’empruntent les innovations ne suivent que rarement ceux qui leur étaient tracés. Ce que l’on peut néanmoins constater avec le développement des nouvelles intelligences artificielles, c’est que ces dernières concernent plus largement des tâches qualifiées que l’on pensait moins exposées aux possibles automatisations. Par ailleurs, les évolutions des métiers du fait de nouvelles technologies sont en réalité fréquentes et parfois radicales. Celle du monde agricole a largement modifié le profil des emplois (et aussi le nombre d’agriculteurs), l’informatique en général a bouleversé de nombreux métiers en quelques dizaines d’années…

Références

1 | Goldman Sachs, “Generative AI could raise global GDP by 7 %”, 5 avril 2023. Sur goldmansachs.com

2 | Eloundou T et al., “GPTs are GPTs : an early look at the labor market impact potential of large language models”, 23 mars 2023. Sur ar5iv.labs.arxiv.org (pré-publication non évaluée par les pairs).

3 | « IBM veut remplacer des milliers d’emplois par l’intelligence artificielle », Le Point, 3 mai 2023. Sur lepoint.fr

Des risques non maîtrisables ?

L’irruption de ChatGPT (suivi par des annonces de plusieurs concurrents) a réactivé certains discours apocalyptiques face à des intelligences artificielles qui pourraient devenir incontrôlables [7]. Arriverait ainsi un moment (appelé « singularité ») où l’intelligence artificielle dépasserait l’intelligence humaine et, par un processus d’emballement, menacerait l’existence même de notre société [8].

Si les craintes extrêmes sont en général peu prises au sérieux par les experts du domaine (voir par exemple [3]), les dangers d’un développement non maîtrisé sont, eux, bien réels. Parmi les problèmes soulevés, mentionnons les risques accrus de désinformation et de manipulation, les biais qui entachent l’apprentissage des systèmes, et donc les résultats produits (voir encadré) ou encore les erreurs (ou « hallucinations »), particulièrement si ces IA sont intégrées dans des systèmes critiques (conduite autonome ou armement par exemple).

Les systèmes d’IA génératives sont entraînés sur des jeux de données qui reflètent par nature une vision partielle du monde. Dans le cas de ChatGPT4, c’est une partie d’Internet, figée en 2021, qui a été utilisée. Les IA génératives ne font, d’une certaine manière, que prolonger le contenu existant. Même si des filtres sont ajoutés pour contrôler certaines interactions, des biais de toutes natures vont affecter les textes générés.

Cela n’est pas propre aux IA génératives et se retrouve plus généralement dans tous les systèmes fondés sur l’apprentissage machine. On se souvient ainsi qu’en 2015, Amazon avait dû mettre de côté son « robot recruteur » car il favorisait les candidatures masculines pour les postes techniques. Ce biais provenait du fait que l’IA avait été formée sur des données portant sur les personnes déjà en place dans l’entreprise, majoritairement des hommes [1]. En 2016, Microsoft a arrêté son expérience avec le robot conversationnel Tay après que celui-ci a commencé à poster des messages injurieux et offensants sur Twitter. Cela s’est produit parce que Tay avait été inondé de messages racistes, antisémites et misogynes par un groupe d’utilisateurs, et avait simplement reproduit les comportements qu’il observait [2]. On peut également citer les systèmes de reconnaissance faciale, autorisés dans certains pays ou dans certains lieux, qui ont tendance à commettre plus d’erreurs sur certaines parties de la population (par exemple, les Noirs, les Asiatiques ou les femmes aux États-Unis [3]). Là aussi, ce sont les données ayant servi pour l’entraînement qui sont en cause.

Ainsi, les IA génératives, fondées sur des algorithmes similaires, n’échappent pas à la production de contenus biaisés. OpenAI, l’entreprise derrière ChatGPT, le reconnaît explicitement et affirme faire de la correction de ses biais une de ses actions pour une « IA éthique » [4].

Pour remédier à ce problème de biais, une solution consiste à ajouter des filtres et des couches logicielles dont l’apprentissage aura été supervisé par des êtres humains. Mais cette solution reste coûteuse et introduit par ailleurs la subjectivité des superviseurs, autre source de biais possibles [5].

Références

1 | “Amazon ditched AI recruiting tool that favored men for technical jobs”, The Guardian, 11 octobre 2018.

2 |“In 2016, Microsoft’s racist chatbot revealed the dangers of online conversation”, IEEE Spectrum, 25 novembre 2019. Sur spectrum.ieee.org

3 | Rauenzahn B,“Facing bias in facial recognition technology”, The Regulatory Review, 20 mars 2021. Sur theregreview.org

4 | « Comment ChatGPT gère-t-il les biais ? », ChatGPT Info, 2023. Sur chatgpt-info.fr

5 | Ferrara E, “Should ChatGPT be biased ? Challenges and risks of bias in large language models”, 20 avril 2023, 1-23. Sur arxiv.org (pré-publication non évaluée par les pairs).

La réglementation

Pour faire face à ces risques, le type de réglementation à mettre en place fait débat. Certains doutent même de l’efficacité d’une réglementation qui serait vouée à toujours courir derrière l’innovation et, finalement, risquerait de constituer un frein à celle-ci [9]. Ainsi, Sam Altman, le dirigeant d’OpenAI, constatant que « l’intelligence artificielle a le potentiel d’améliorer à peu près tous les aspects de nos vies, mais (…) crée aussi des risques sérieux », plaide pour la mise en place d’un cadre réglementaire tout en soulignant que « si l’industrie américaine ralentit, la Chine ou quelqu’un d’autre peut progresser plus vite » [10].

Gardons également en tête que bon nombre des questions soulevées ne sont pas propres aux IA génératives, ni même parfois aux systèmes d’intelligence artificielle. On retrouve avec le numérique en général des thèmes déjà connus relatifs à la désinformation ou à la protection des données privées. Reste que les IA en général et les IA génératives en particulier posent des problèmes spécifiques qui ont conduit l’Union européenne à proposer un cadre réglementaire distinguant plusieurs niveaux de risques (de « risque minimal » à « risque inacceptable » – donc interdit) [11] (voir l’article sur ce sujet dans ce dossier de Science et pseudo-sciences).

Conclusion

Il se peut que nous vivions les prémices d’une nouvelle révolution technologique. Difficile alors de prédire les formes qu’elle prendra précisément, son ampleur future et ses répercussions sur la société en général. Il se peut aussi que les difficultés rencontrées entraînent un nouveau repli médiatique, comme la discipline nous y a habitués. Ce repli temporaire laisserait néanmoins des outils et des applications importantes, avec leur lot d’opportunités qui seront à exploiter, mais aussi de risques qui seront à gérer.

D’une façon générale, depuis l’invention de l’imprimerie, « les révolutions de l’information sont l’état normal de la vie humaine » (voir le dernier encadré) et il n’est peut-être pas fondé d’attribuer à l’IA présente ou à venir tous les maux de la société [12].

« Pendant des siècles, les nouvelles technologies de l’information n’ont cessé d’arriver et d’accélérer le changement et la démocratisation de l’information : progrès du papier, gravure sur bois, imprimerie à caractères mobiles, télégraphie, radio, télévision. À l’instar de notre révolution numérique, aucune des révolutions informationnelles précédentes ne s’est produite d’un seul coup : en 1450, ce sont les volumineuses bibles de Gutenberg ; quarante ans plus tard, les minces livres de poche ; vingt ans après, les réseaux de diffuseurs de nouvelles et de brochures. En 1517, les quatre-vingt quinze thèses de Luther étaient imprimées à Londres dix-sept jours après leur publication à Wittenberg, alors que les habitants de Londres et de Wittenberg se souvenaient que des scribes experts mettaient six mois à réaliser un livre – tout comme beaucoup d’entre nous se souviennent des disquettes et de l’accès à Internet par le réseau téléphonique commuté […].

Les moyens de subsistance du scribe, du fabricant de plumes, du dactylographe et du photographe professionnel ont tous été menacés par les révolutions de l’information. Ils ont eu besoin de filets de sécurité, de recyclage, de transformation de leurs emplois en de nouveaux emplois. Mais nous connaissons aujourd’hui ces dangers et nous pouvons nous y préparer. Les révolutions de l’information nécessitent des transitions réfléchies. Lorsque le tableur numérique est apparu, permettant de faire en quelques secondes ce qui prenait des semaines aux comptables, ces derniers se sont mis à l’utiliser et à en faire plus. Si une IA peut réussir l’examen écrit du barreau, les informations relatives à l’examen du barreau seront à la portée de tous, tandis que les avocats de la prochaine génération s’entraîneront à l’aide de procès en réalité virtuelle et apprendront à compiler des documents rapidement avec l’aide de l’IA. Ce sont des compétences qui permettront à une personne pauvre d’obtenir les documents dont elle a besoin en une heure de temps d’avocat, coûteux, plutôt qu’en dix. C’est cela démocratiser l’information.

Les dangers du ChatGPT et de ses successeurs ne résident pas dans les technologies elles-mêmes. Ils résident dans le fait que nous devons maintenant faire des choix, bons ou mauvais, sur la manière dont nous aidons les personnes à surmonter les effets du déploiement. »

Ada Palmer, professeure d’histoire, université de Chicago.

Extrait de : Palmer A, “We are an information revolution species”, AI Anthology, 2023. Sur unlocked.microsoft.com

Et il est certainement infondé d’évoquer un « grand remplacement de l’Homme par la machine » et peut-être un peu trop optimiste d’évoquer une « émancipation grâce à l’IA ». Comme pour toute technologie, ce sont les usages que décideront d’en faire les sociétés et l’encadrement qu’elles mettront en place qui seront déterminants.

1 | Krivine JP, « Intelligence artificielle : le présent éclairé par l’histoire », SPS n° 332, avril 2020. Sur afis.org

2 | Bubeck S et al.,“Sparks of artificial general intelligence : early experiments with GPT-4”, 2023, 1-155. Sur arxiv.org (pré-publication non évaluée par les pairs).

3 | Browning J, Le Cun Y, “AI and the limits of language”, Noema, 23 août 2022. Sur noemamag.com

4 | Heikkilä M, Heaven D, “Yann LeCun has a bold new vision for the future of AI”, MIT Review, 24 juin 2022. Sur technologyreview.com

5 | Turing A, “Computing machinery and intelligence”, Mind, 1950, 59 :433-60.

6 | Hub France IA, « ChatGPT : usages, impacts et recommandations », mai 2023. Sur hub-franceia.fr

7 | Yudkowsky E, “Pausing AI developments isn’t enough : we need to shut it all down”, Time, 29 mars 2023. Sur time.com

8 | Ganascia JG, « Le mythe de la singularité technologique ». Sur afis.org

9 | Cimino V, « Le futur règlement européen sur l’intelligence artificielle peut-il être un frein à l’innovation ? », Siècle Digital, 18 novembre 2021. Sur siecledigital.fr

10 | « ChatGPT : même le patron d’OpenAI, qui a créé l’interface, demande aux gouvernements d’intervenir », HuffPost, 16 mai 2023. Sur huffingtonpost.fr

11 | Commission européenne, « Proposition cadre réglementaire sur l’intelligence artificielle », site web « Bâtir l’avenir numérique de l’Europe », septembre 2022. Sur digital-strategy.ec.europ.eu

12 | Palmer A, “We are an Information Revolution Species”, AI Anthology, 2023. Sur unlocked.microsoft.com

Publié dans le n° 345 de la revue

Partager cet article

L' auteur

Jean-Paul Krivine

Rédacteur en chef de la revue Science et pseudo-sciences (depuis 2001). Président de l’Afis en 2019 et 2020. (…)

Plus d'informationsIntelligence Artificielle

L’intelligence artificielle (IA) suscite curiosité, enthousiasme et inquiétude. Elle est présente dans d’innombrables applications, ses prouesses font régulièrement la une des journaux. Dans le même temps, des déclarations médiatisées mettent en garde contre des machines qui pourraient prendre le pouvoir et menacer la place de l’Homme ou, a minima, porter atteinte à certaines de nos libertés. Les performances impressionnantes observées aujourd’hui sont-elles annonciatrices de comportements qui vont vite nous échapper ?

Intelligence artificielle

Le 16 août 2020

IA génératives : une révolution en cours ?

Le 17 octobre 2023

De l’analyse de la langue aux modèles génératifs

Le 11 octobre 2023

Les systèmes d’intelligence artificielle pour la génération d’images

Le 5 octobre 2023

IA génératives : un risque accru de désinformation ?

Le 29 septembre 2023